Définitions de base de la gestion de l'innovation et du contrôle statistique des processus (Statistical Process Control, SPC)

Synergie

La synergie est l'effet combiné de facteurs, caractérisé par le fait que leur effet combiné dépasse largement l'effet de chaque composant individuel et leur simple somme. Un état de fait habituellement véhiculé par l'expression « le tout est plus grand que la somme de ses parties » : 1+1=2x, où x>1.

Émergence

L'émergence (émergence anglaise - émergence, émergence d'une nouvelle chose) dans la théorie des systèmes est la présence de propriétés spéciales dans tout système qui ne sont pas inhérentes à ses sous-systèmes et blocs, ainsi que dans la somme d'éléments non reliés par des systèmes spéciaux formant un système. Connexions; irréductibilité des propriétés d'un système à la somme des propriétés de ses composants ; synonyme : « effet systémique ».

Additivité

L'additivité est une propriété des grandeurs par rapport à l'addition, consistant dans le fait que la valeur d'une grandeur correspondant à l'objet entier est égale à la somme des valeurs des grandeurs correspondant à ses parties : 1+1=2.

Non-additivité

La non-additivité est à l'opposé du concept d'additivité, une relation dans laquelle le tout n'est pas déterminé par ses parties et le tout ne peut être connu et expliqué sur la base de la seule connaissance de ses parties (le tout est plus grand ou plus petit que le somme de ses parties) : 1 + 1 = 2x, où x < ou > 1.

« L'incapacité du management à comprendre l'interdépendance entre les composants du système, combinée à une gestion par objectifs, entraîne de grandes pertes. Les efforts des différentes divisions de l'entreprise qui effectuent leur travail ne s'additionnent pas : ils sont interdépendants. Une division, dans un effort pour atteindre ses objectifs, peut « tuer » une autre division.

Variabilité

La variabilité est la variabilité, l'incertitude, la variété, la propagation ou une mesure de l'écart par rapport à « l'optimum ». Le changement lui-même est appelé variation ou variante. Voir l'article pour plus de détails : Nature de la variabilité .

Qualité de classe mondiale

"Le concept de 'réglage précis avec un minimum de variance' définit une qualité de classe mondiale depuis trente ans ! Et plus tôt vous ferez de ce principe la règle de votre vie, plus vite vous deviendrez compétitif !"

Voir description Fonctions de perte de Taguchi , expliquant cette définition simple et succincte de la qualité de classe mondiale.

Pensée statistique

La pensée statistique est une méthode de prise de décision basée sur la théorie de la variabilité quant à l’opportunité d’intervenir ou non dans un processus et, si nécessaire, à quel niveau.

« Premièrement, si le résultat d’un processus est déterminé par l’influence de causes particulières, alors son comportement change de manière imprévisible et, par conséquent, il est impossible d’évaluer l’effet des changements dans la conception, la formation, les politiques d’approvisionnement en composants, etc., qui pourraient être introduit par la direction dans ce processus (ou dans le système qui contient ce processus) à des fins d'amélioration. Tant que le processus est dans un état incontrôlé, personne ne peut prédire ses capacités.

Deuxièmement, lorsque les causes particulières ont été éliminées de sorte que seules subsistent les causes générales de variation, les améliorations peuvent alors dépendre de mesures de contrôle. Puisque dans ce cas, les variations observées du système sont déterminées par comment et de quelle manière les processus et le système ont été conçus et construits, alors seul le personnel de direction, les cadres supérieurs ont le pouvoir de modifier le système et les processus.

Eh bien, quelle est la différence ? Et qu'est-ce que cela nous donne ? Oui, tout ce qui sépare le succès de l’échec !

Troisièmement, nous arrivons au problème suivant : si nous ne distinguons pas (en pratique) un type de variabilité d’un autre et agissons sans comprendre, non seulement nous n’améliorerons pas les choses, mais nous les aggraverons certainement. Il est clair qu’il en sera ainsi et cela restera un mystère pour ceux qui ne comprennent pas la nature de la variabilité (des variations). »

Degré raisonnable de contrôlabilité statistique

« Puisque les cartes de contrôle sont conçues pour détecter le manque de contrôlabilité statistique, la présence constante d'un processus dans les limites établies peut être considérée comme un indicateur de contrôlabilité statistique. Si nous, comme Shewhart, considérons l'état de contrôlabilité statistique comme un certain idéal, qui en pratique ne peut être approché, alors avant nous poserons inévitablement la question d'un critère qui nous permet d'évaluer à quel point notre processus est proche de cet idéal.

Lorsqu'il est appliqué aux graphiques de moyennes et de plages d'un processus décrit à l'aide de sous-groupes composés de quatre éléments, Shewhart a proposé le critère suivant de contrôlabilité minimale : si au moins 25 sous-groupes consécutifs ne montrent pas de signes de manque de contrôle statistique, alors un tel processus est considéré comme ayant un degré raisonnable de contrôlabilité.

Dans sa prochaine proposition, Shewhart interprète ce critère minimum en termes de nombre total d'observations présentes, il peut donc être adapté comme suit : lorsqu'au moins 100 observations consécutives ne montrent aucune perte de contrôlabilité, le processus peut être considéré comme présentant un degré raisonnable de contrôlabilité statistique.

En proposant un critère de contrôlabilité minimale, Shewhart a souligné qu'il existe une différence fondamentale entre l'absence de signes d'incontrôlabilité et la conclusion selon laquelle le processus est dans un état de contrôlabilité statistique. L'absence de signes d'incontrôlabilité peut s'expliquer par les particularités de l'intervalle de temps décrit par la carte.

Des causes particulières peuvent apparaître et disparaître, et des périodes d'observation relativement courtes peuvent ne pas révéler de points situés en dehors des limites de contrôle. Cependant, plus on accumule d'observations qui ne révèlent la présence d'aucune cause particulière, plus on est sûr que le processus est dans un état de contrôle statistique. Shewhart a également noté qu'on peut être pratiquement sûr de la contrôlabilité d'un processus lorsque non pas 100, mais 1 000 mesures consécutives ne révèlent pas un manque de contrôlabilité.

"Un phénomène devrait être qualifié de contrôlable lorsque, en utilisant l'expérience passée, nous pouvons prédire, au moins dans certaines limites, quelles variations on peut en attendre dans le futur."

Approche scientifique et théorie de la connaissance de quelque chose

Cycle de l'approche scientifique : Etude des phénomènes observés - élaboration d'une théorie (hypothèse) qui explique l'observation et les définitions opérationnelles - prédiction du comportement ultérieur des phénomènes sur la base de la théorie développée, en tenant compte des limites d'applicabilité - vérification la conformité de l'observation suivante avec la théorie développée - la confirmation de la théorie ou son ajustement, ou peut-être un rejet complet du développement d'une nouvelle théorie.

Un extrait du System of Deep Knowledge (Elements of the Theory of Knowledge) d'Edwards Deming, qui est directement lié à l'essence de l'approche scientifique :

- Aucun nombre d’exemples ne crée une théorie. Mais au moins un échec dans une théorie nécessite sa révision, voire son abandon.

- Presque toutes les actions de gestion nécessitent des prévisions.

- Une déclaration qui ne contient pas de prédiction n’est d’aucune utilité pour un leader.

- Par définition, la prédiction est impossible dans un système instable.

- L'interprétation des données d'un test ou d'une expérience est une prédiction.

- Importance définitions opérationnelles , qui donnent aux concepts un sens qui peut être transmis aux autres.

- Il n’existe aucune valeur réelle d’une caractéristique, d’un état ou d’une condition déterminée par la mesure ou l’observation.

L’approche scientifique nous encourage à prendre des décisions et à formuler des politiques fondées sur de bonnes informations, tant quantitatives que qualitatives, et pas seulement sur des perceptions personnelles ou des considérations à court terme. Cela implique souvent d'analyser des informations à l'aide de méthodes statistiques (Statistical Process Control, SPC), mais implique également de connaître et de comprendre les limites de ces méthodes, notamment une conscience de l'importance critique de phénomènes qui ne peuvent être décrits numériquement. Deming cite souvent Lloyd Nelson, chef du département des méthodes statistiques chez Nashua Corporation :

« Les facteurs les plus importants nécessaires à la gestion d’une organisation sont généralement inconnus et ne peuvent être quantifiés. »

Peu scientifique

Un signe important de non-science est le manque de pouvoir prédictif.

« La théorie de la connaissance nous enseigne que tout énoncé est porteur de connaissance lorsqu’il est capable de prédire des résultats futurs et correspond à l’expérience passée sans aucune exception. »

Erreur du premier type (surréglementation)

L'erreur du premier type (surrégulation) est l'interprétation des causes générales des variations comme particulières et, par conséquent, une réaction à tout événement qui dépasse les limites de tolérance ou n'atteint pas l'objectif fixé, sous la forme d'un événement externe. action corrective (interférence dans le fonctionnement du système), introduisant une variabilité encore plus grande.

Dessin. Erreur du premier type (surréglementation)

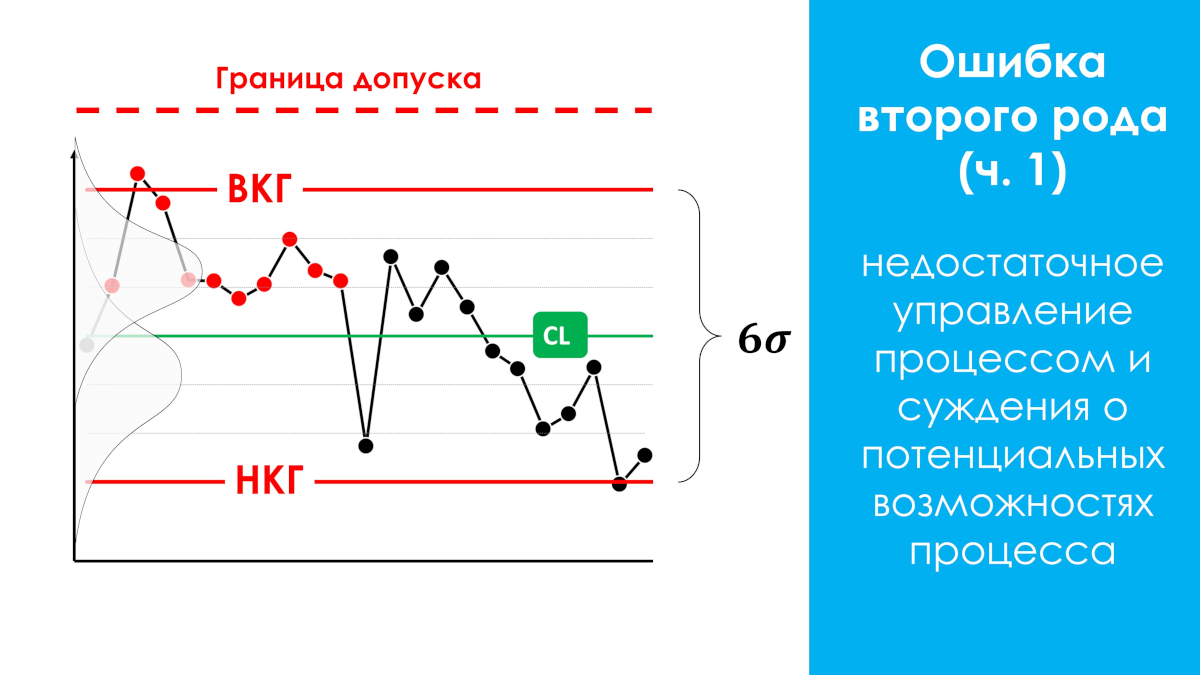

Erreur du deuxième type (contrôle de processus insuffisant)

Erreur du deuxième type (contrôle de processus insuffisant) - jugements sur les capacités potentielles d'un processus qui est dans un état statistiquement incontrôlable (non contrôlé), car de tels jugements ne peuvent être appliqués qu'à des processus avec une prédominance de causes communes de variation, c'est-à-dire ceux qui sont dans un état statistiquement contrôlé. Défaut de prendre des mesures pour éliminer les causes particulières si les variations provoquées par celles-ci rentrent dans les limites de tolérance.

Dessin. Erreur du deuxième type (contrôle insuffisant)

« Ces deux erreurs coûtent très cher ! N’importe qui peut se fixer une règle impeccable : ne jamais commettre d’erreur du 1er type.

C'est simple : il suffit de relier la variation dans tous les cas à des causes communes. Cependant, cela maximise les pertes liées à la commission d’une erreur de type 2. Et vice versa, en refusant de commettre une erreur de type 2 en attribuant toute variation à des causes particulières, on augmente les pertes d’une erreur de type 1.

Ce serait formidable de ne jamais commettre d'erreurs du premier ou du deuxième type, mais malheureusement, cela est impossible. Shewhart s'est fixé un objectif complètement différent : ne pas avoir peur de commettre les deux types d'erreurs, mais réguler la fréquence de ces erreurs de manière à minimiser les pertes économiques des deux types. En conséquence, il a créé un outil : une carte de contrôle avec des limites au niveau sigma 3x. Depuis, sa carte de contrôle a produit des résultats étonnants dans une grande variété de domaines d’application. Ça marche vraiment!

Le contrôle statistique peut être obtenu en recherchant chaque cause spécifique, en l'identifiant chaque fois qu'un point dépasse les limites de contrôle et en prenant les mesures appropriées.

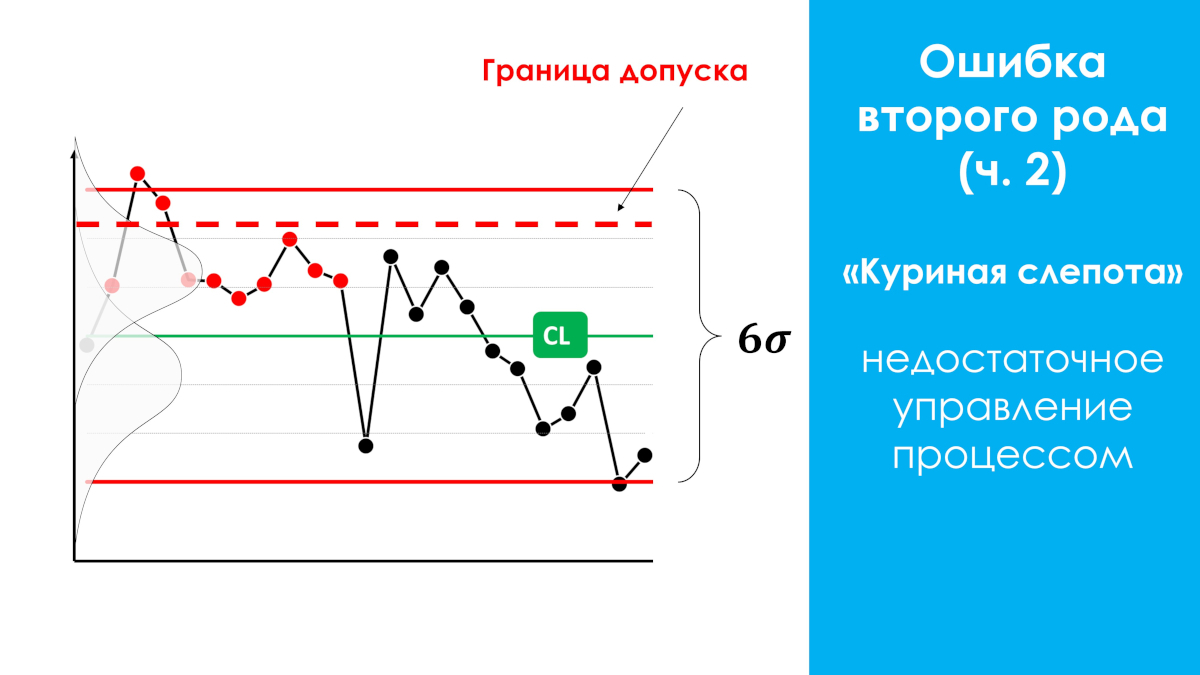

Erreur du deuxième type, un cas particulier (cécité nocturne). Se produit le plus souvent.

Si le processus produisant un produit défectueux par rapport aux limites de tolérance est dans un état statistiquement incontrôlable (voir figure ci-dessous), intervenir dans le processus lorsque certaines valeurssont en dehors des limites de tolérance peut avoir un effet positif sur le processus. sortie, mais est toujours inefficace (effort-résultat), car il existe une forte probabilité de manquer des causes particulières d'incontrôlabilité, qui pourraient être identifiées par la carte de contrôle Shewhart en certains points, mais sont situées dans la zone de tolérance, ce qui conduit à « la nuit ». cécité» des observateurs - incapacité à utiliser des opportunités supplémentaires pour améliorer le processus.

La cécité nocturne est le phénomène le plus courant. Ce cas particulier d’erreur de type II n’a jamais été expliqué séparément dans les sources scientifiques étrangères et russes. En 2021, une description a été faite et un nom a été donné à ce cas particulier par le directeur scientifique de notre centre AQT S.P. Grigoryev.

Dessin. Erreur de type II, cas particulier (cécité nocturne)

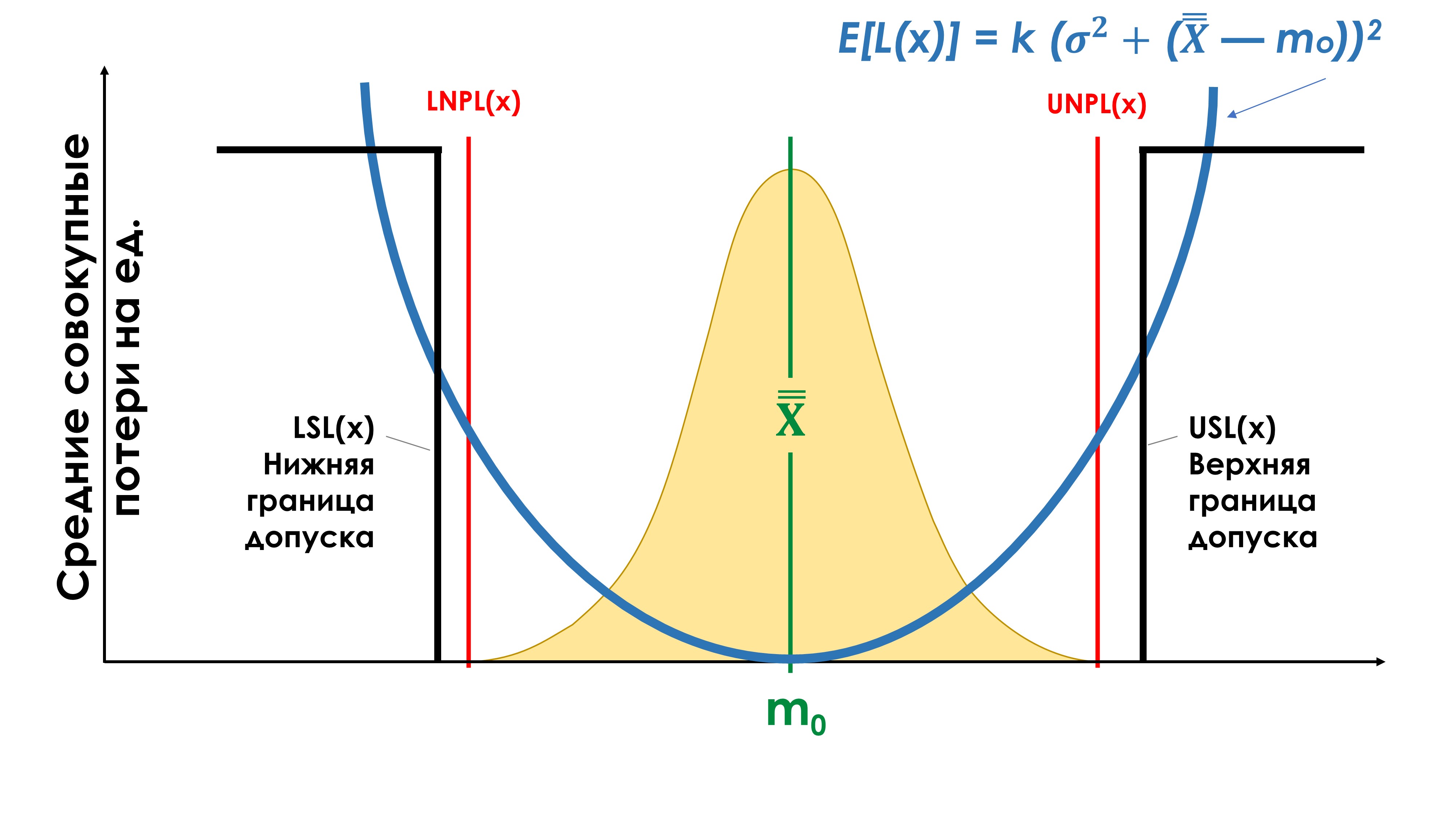

Fonction de perte de qualité Taguchi

Le scientifique japonais Genichi Taguchi a proposé une nouvelle approche pour évaluer la qualité des produits. L'idée traditionnelle de la qualité des produits est que tous les produits fabriqués sont de qualité égale si leurs indicateurs de qualité (ou paramètres) répondent aux exigences de la documentation technique, qui définit la tolérance pour ces indicateurs (paramètres). Autrement dit, dans la zone de tolérance, les pertes de qualité sont nulles. Si les indicateurs de qualité dépassent les limites de tolérance (LSL) et (USL), alors les pertes de qualité sont déclarées inacceptables. Taguchi a appelé cette fonction de perte de qualité (voir la figure ci-dessous, une ligne droite pointillée) une « fonction discontinue de type seuil ».

"Il ressort clairement de la fonction de Taguchi que le respect des exigences de tolérance n'est en aucun cas un critère suffisant pour juger de la qualité. Cette tentative est en contradiction flagrante avec l'insistance sur l'amélioration continue, l'un des principes fondamentaux de la philosophie de Deming. En effet, la dernière des approches se caractérise par une recherche constante dans le sens d'une amélioration de la qualité, tandis que la première n'incite pas à mieux travailler, dès lors que les exigences de tolérance sont déjà satisfaites.

En revanche, l'éthique sous-jacente à certaines approches établies en matière de qualité, y compris les méthodologies du coût de la qualité, tend à décourager de nouveaux efforts d'amélioration au motif que si les besoins du client ont été satisfaits, il faudra investir davantage de temps, d'efforts et de dépenses dans ce processus particulier. n'est pas justifié. ".

« Le recours aux tolérances (cahier des charges, spécifications techniques, spécifications techniques) n'est pas une erreur. Ce n’est tout simplement pas suffisant.

"Le concept du Dr Taguchi, basé sur l'analyse de la fonction de perte, conduit inévitablement à une nouvelle définition de la qualité de classe mondiale : juste sur la cible avec une variance minimale ! La première exigence - 'juste sur la cible' - signifie que la moyenne du processus est définie de telle sorte que qu'il soit aussi proche que possible de la cible (nominale). La deuxième exigence, « variance minimale », signifie que le processus doit avoir un degré raisonnable de contrôle statistique.

Le non-respect du principe « conformément à l'objectif avec un écart minimal » entraînera inévitablement une augmentation significative des pertes moyennes par unité de production. Ces pertes peuvent être très graves, mais elles sont toujours inutiles.

Le « respect de la tolérance », le « zéro défaut », la « qualité Six Sigma », le « coût de la qualité » et tous les autres médicaments basés sur la tolérance ne peuvent tout simplement pas satisfaire à ce principe. Le concept de « réglage précis de l'objectif avec un minimum de variance » définit la qualité de classe mondiale depuis trente ans ! Et plus tôt vous ferez de ce principe la loi principale de votre vie, plus vite vous deviendrez compétitif !

L'application de l'approche qualité résultant de la fonction Taguchi doit être appliquée lors de l'utilisation de tout autre indicateur de qualité avec des limites « de » et « à », par exemple les délais de livraison au titre du contrat, etc.

Système de mesure

Un système de mesure est le résultat de l'interaction entre l'instrument de mesure utilisé, la méthode de mesure, l'environnement et l'opérateur.

Chaque opérateur de machine qui mesure une pièce lors de sa fabrication fait partie de son propre système de mesure, qui possède ses propres incertitudes (variabilité, erreur), biais et peut être dans un état statistiquement contrôlé (stable) ou incontrôlé (imprévisible). Un système de mesure qui se trouve dans un état statistiquement incontrôlable est inutile. Le système de mesure des contrôleurs est un autre système de mesure. Lorsque l'opérateur soumet ses produits au contrôle, il détermine leur conformité aux tolérances grâce à son système de mesure unique. L'évaluation et la cohérence des systèmes de mesure doivent être effectuées avant de surveiller les processus de travail.

Avez-vous convenu de vos systèmes de mesure avec vos fournisseurs et clients ?

Genichi Taguchi

Genichi Taguchi (né en 1924) est un statisticien japonais bien connu de la seconde moitié du XXe siècle. Il développe les idées de la statistique mathématique, liées notamment aux méthodes statistiques de conception expérimentale et de contrôle qualité. Taguchi a été le premier à relier les coûts économiques et la qualité à une relation mathématique, en introduisant le concept fonctions de perte de qualité . Il a été le premier à démontrer que des pertes de qualité se produisent également dans la plage de tolérance.

À notre avis, le manque d’attention portée aux méthodes de Taguchi est l’une des raisons du sérieux retard des entreprises russes dans le domaine de l’amélioration de la qualité des processus et des produits.

Peter Scholtes

Peter Scholtes (1938-2009), l'un des consultants et éducateurs les plus célèbres en Occident dans le domaine des méthodes de gestion de la qualité, développant les idées du Dr Deming. Lire le chapitre : La méthode du « management par objectifs », qu'est-ce qui ne va pas ? tiré du livre « Team Handbook » de Peter Scholtes [7].

Site Internet de Peter Scholtes : www.pscholtes.com

Walter Andrew Shewhart

Walter Andrew Shewhart (Walter A Shewhart, 1891-1967), né à New Canton, pc. Illinois en 1891. Diplômé de l'Université de l'Illinois. Plus tard, il reçut un doctorat en physique de l'Université de Californie (1917).

En 1931, Shewhart publie un rapport sur l'utilisation des cartes de contrôle et son premier livre, Economic Management of Industrial Quality. 1939 est devenue une date particulière dans la biographie du professeur Shewhart de l’Université Rutgers. Puis son deuxième livre [9] « Méthode statistique du point de vue du contrôle qualité » est publié. À la fin de la décennie, Shewhart a résumé les résultats des travaux sur la méthode statistique de contrôle de la qualité de la production et des processus technologiques et garantissant, sur cette base, la qualité des produits manufacturés. Premier professeur et plus vieil ami d'Edwards Deming.

Donald J. Wheeler

Donald J. Wheeler est un statisticien-conseil qui a eu la chance de travailler avec David Chambers de 1970 à 1989.

Depuis 1971, Wheeler enseigne le contrôle statistique des processus, d'abord aux étudiants de l'Université du Tennessee, puis aux responsables industriels du monde entier.

Depuis le milieu des années 1970, il travaille activement comme consultant.

En 1974, Donald Wheeler assista pour la première fois aux conférences du Dr Deming et resta pour toujours son élève.

À partir de 1981, il assiste parfois Edwards Deming dans la conduite de ses séminaires de quatre jours. Sa propre philosophie de l'amélioration des processus repose fermement sur la philosophie de Deming. Donald Wheeler est l'auteur ou co-auteur de six livres et de plus de 60 articles sur le contrôle statistique des processus.

Il a eu l’occasion de travailler avec une grande variété d’entreprises industrielles à travers le monde. Il donne des conférences aux États-Unis et à l'étranger.

Donald Wheeler est titulaire d'un baccalauréat en physique et en mathématiques de l'Université du Texas à Austin, ainsi que d'une maîtrise et d'un doctorat de la Southern Methodist University.

De 1970 à 1982, il a enseigné au département de statistiques de l'Université du Tennessee. En 1982, Wheeler quitte l'enseignement pour se consacrer au conseil dans l'industrie et dans d'autres domaines. Donald Wheeler vit actuellement à Knoxville, Tennessee.

Le Dr Donald J. Wheeler est membre de l'American Statistical Association et de l'American Society for Quality, récipiendaire de la médaille Deming 2010, et est l'une des principales autorités mondiales en matière de contrôle des processus statistiques et d'analyse appliquée des données.

Co-auteur d'un livre à succès [4] "Contrôle statistique des processus. Optimisation commerciale à l'aide des cartes de contrôle Shewhart" / "Comprendre le contrôle statistique des processus". Extrait de l'avant-propos d'Edwards Deming à ce livre :

« C’est un grand honneur pour moi d’écrire l’avant-propos du livre de mon ami le Dr Donald Wheeler.

...

En conclusion, j'aimerais profiter de cette occasion pour saluer les réalisations mathématiques du Dr Wheeler. Sa compréhension de la théorie et de la pratique repose sur une compréhension approfondie des mathématiques. Et je suis heureux d'avoir l'opportunité d'apprendre de lui."

Donald Wheeler, auteur de nombreux articles dans des publications scientifiques sur l'utilisation des cartes de contrôle Shewhart dans l'industrie, il nous en a aimablement fourni quelques-uns, et nous les avons traduits en russe et les avons publiés sur notre site Internet dans la rubrique :

connaissances fondamentales

.

Liste des articles originaux :

[9], [19], [20], [21], [25], [26], [29], [31], [33], [34], [35]

-Donald Wheeler.

David S. Chambers

David S. Chambers (1917-1989) était un ami proche et un collègue du Dr William Edwards Deming ainsi qu'un consultant et professeur de renommée internationale en contrôle des processus statistiques.

Il a été membre, président et président du conseil d'administration de l'American Society for Quality Control (ASQC), récipiendaire du prix Eugene Grant et académicien de l'Académie internationale de la qualité. Une liste de ses collègues et anciens étudiants pourrait facilement servir de Who's Who ? dans le domaine du contrôle qualité.

David Chambers est né à Clarksville, au Texas. Il a obtenu sa licence et sa maîtrise à l'Université du Texas, où il a enseigné de 1941 à 1947 avant de devenir professeur adjoint de statistiques à la Tennessee State University. Ici, il a travaillé comme professeur de statistiques de 1958 à 1981, après quoi il a pris sa retraite, ce qui lui a permis de se concentrer sur l'enseignement. Selon le Dr Deming, la perte d’une telle personne est irremplaçable.

Myron Tribus

Myron Tribus, directeur d'Exergy, partageait son temps entre Exergy Corporation, une entreprise pionnière de nouvelles approches en matière de production d'électricité, et son travail de consultant en gestion de la qualité.

Fort de trente ans d’expérience en tant qu’enseignant, il a également occupé le poste de secrétaire adjoint chargé de la science et de la technologie au ministère américain du Commerce.

Il a été vice-président senior de Xerox Corporation et directeur du Center for Engineering Excellence. Myron Trybus était un disciple du Dr Edwards Deming. Lire l'article de Myron Trybus Théorie virale de la gestion où il fait une analogie avec la médecine du 19e (19e) siècle et la gestion du 20e (20e) siècle pour illustrer pourquoi la société adhère aux paradigmes dominants et résiste au changement afin d'améliorer nos vies.

Henry R. Neave

Henry R. Neave. Le Dr Henry Neave a rencontré Edwards Deming au milieu des années 1980 et est immédiatement devenu son ami proche. Depuis lors, il a continuellement assisté Deming dans ses séminaires de quatre jours en Europe, ainsi que dans d'autres séminaires, conférences et événements organisés des deux côtés de l'Atlantique.

C'est Deming qui a encouragé Neave, en tant qu'expert reconnu de la philosophie de Deming, à reprendre le livre [1] « L'espace du Dr Deming : principes pour construire une entreprise durable ». Edwards Deming lui-même a écrit l'avant-propos de ce livre.

Il est préférable de commencer à étudier la théorie du management d'Edwards Deming avec ce livre.

En 1987, c'est à l'initiative du Dr Neave que fut créée la British Deming Association, au sein de laquelle Neave occupe aujourd'hui le poste de directeur de l'éducation. Pendant de nombreuses années, le Dr Neave a enseigné les statistiques à l’Université de Nottingham, en Angleterre. Depuis 1996, il est chargé de cours à temps plein en gestion au département de qualité de l'université Trent de Nottingham.

Alfie Kohn

Alfie Kohn est un psychologue social de renommée internationale. Voir sur notre site Web les documents préparés à partir des œuvres d'Alfie Kohn dans les articles : Système de motivation du personnel , L’attrait malavisé de la concurrence .

Site personnel d'Alfie Kohn : www.alfiekohn.org